OpenAI، شرکت پیشگام در حوزه هوش مصنوعی، در روز جمعه اعلام کرد که باگی در کتابخانه منبع باز Redis موجب افشای اطلاعات شخصی سایر کاربران و عناوین چت در سرویس ChatGPT شده است. این اتفاق میتواند به عنوان یک مسئله امنیتی جدی در نظر گرفته شود که میتواند منجر به از دست رفتن حریم شخصی کاربران شود.

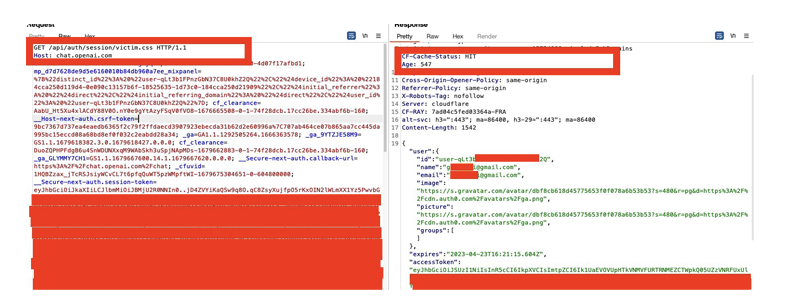

Redis، یک سیستم پایگاه داده با سرعت بالا و قابلیت بالای اطمینان است که برای ذخیره دادههای میانی در ChatGPT استفاده میشود. باگ مذکور، باعث شده تا اطلاعات کاربران از جمله عنوان چت، پیامهای ارسالی، زمان ارسال پیام و حتی مشخصات فردی همچون نام کاربری و ایمیل ذخیره شده در Redis آشکار شوند.

در پی این اتفاق، OpenAI به تمام کاربران ChatGPT پیام داد و از آنها خواست تا اطلاعات حساس و شخصی خود را به روز کنند و بررسی کنند که آیا به صورت غیرمجاز دسترسی به این اطلاعات داشتهاند. همچنین، شرکت OpenAI اعلام کرد که این باگ به سرعت رفع شده و از آن پس تمامی اطلاعات کاربران برای حفظ حریم شخصی آنها با استفاده از رمزنگاری امن ذخیره میشوند.

در کل، باگ در Redis و افشای اطلاعات در ChatGPT نشان میدهد که در این روزها وقتی مسائل امنیتی و حریم شخصی به چالشهای بزرگی تبدیل شدهاند، باید از همه تلاش خود برای جلوگیری از چنین مشکلاتی استفاده کرد. این اتفاق همچنین نشان میدهد که شرکتهایی ک

همچون OpenAI باید به شیوههای بهتری برای حفظ امنیت و حریم شخصی کاربران خود اقدام کنند. این شرکت باید برای جلوگیری از وقوع چنین باگهایی، فرایندهای امنیتی خود را بهبود بخشد و از بهترین شیوههای موجود برای حفظ امنیت استفاده کند.

در عین حال، کاربران نیز باید در جهت حفظ حریم شخصی خود بیشتر دقت کنند و با دقت نسبی به اطلاعات خود در سرویسهای آنلاین دسترسی داشته باشند. بهعلاوه، باید همواره بهروزرسانیهای امنیتی و نرمافزارهای مورد استفادهی خود را اعمال کنند تا از وقوع مشکلاتی همچون افشای اطلاعات شخصی جلوگیری کنند.

در نهایت، افشای اطلاعات شخصی کاربران در ChatGPT نشان میدهد که امنیت و حریم شخصی باید همیشه در اولویت باشد و باید همه تلاش خود را برای جلوگیری از چنین اتفاقاتی انجام دهیم.